Google DeepMind团队训练并发布了Gemma Scope,这是一套在Gemma2模型上训练的稀疏自编码器。它通过编码器和解码器对语言模型的激活进行分解和重构,以期揭示出那些有意义的特征。

Gemma scope采用了一种创新的JumpReLU SAES,它通过一个移位的Heaviside阶跃函数作为门控机制,控制激活,使模型的潜在特征数量得到有效控制。这种设计不仅优化了重建损失,还直接正则化了活跃的潜在特征数量。

训练过程中,模型的激活向量被归化,SAES在不同的层和位置被训练,包括注意力头输出、MLP输出和后MLP残差流。

训练过程中,模型的激活向量被归化,SAES在不同的层和位置被训练,包括注意力头输出、MLP输出和后MLP残差流。

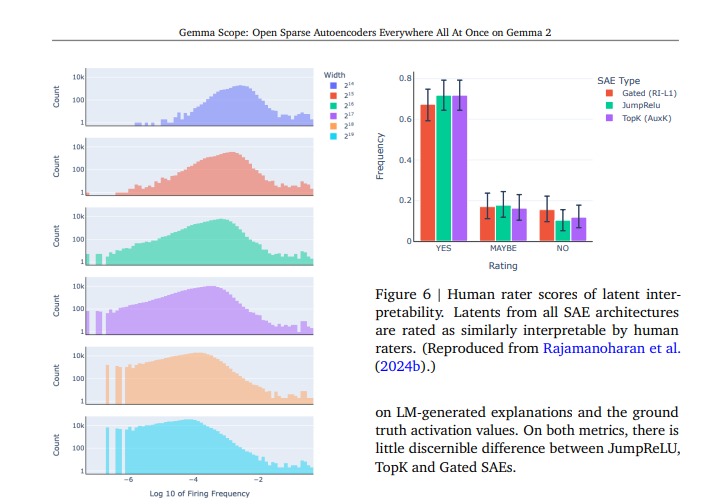

Gemma Scope的性能从多个角度进行了评估。实验结果显示,残差流SAEs的Delta损失通常更高,而序列长度对SAE性能有显著影响。此外,不同数据集子集的表现也不尽相同,Gemma Scope在DeepMind mathematics上表现最佳:

Gemma Scope的发布,为解决一系列开放问题提供了可能。它不仅可以帮助我们更深入地理解SAES还可以改进实际任务的性能,甚至对SAES进行红队测试,以确定它们是否真正找到了模型中的“真实”概念。

随着Gemma Scope的应用,我们有望在Al的可解释性和安全性方面迈出重要一步。它将帮助我们更好地理解语言模型的内部工作机制,提高模型的透明度和可靠性。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

暂无评论...